Создатели программы уверяют, что могут предсказать наклонности человека по одному снимку, а критики называют её «расистской».

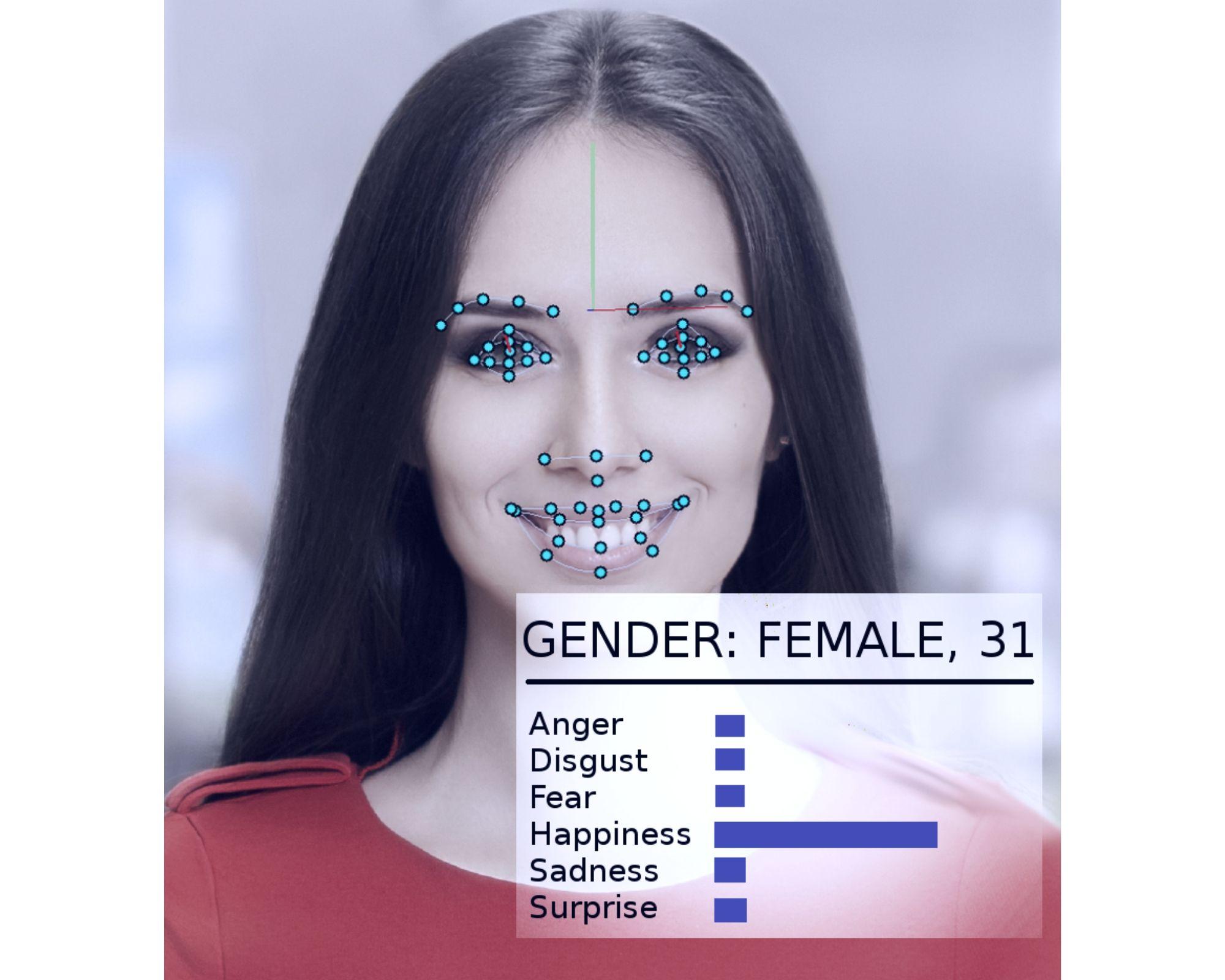

Программу распознавания лиц, которая предсказывает криминальное будущее человека, разработали два профессора и аспирант Харрисбургского университета науки и технологий (США), сообщает Wired. Модель глубокой нейронной сети для прогнозирования преступности с использованием обработки изображений с «80-процентной точностью и без расовой предвзятости» вычисляет криминальные наклонности человека по его фото. Об этом говорится в пресс-релизе, который спустя какое-то время был удалён с сайта вуза из-за разразившегося скандала.

Преступность — одна из наиболее актуальных проблем общества. Разработка технологий, способных выявлять наклонности человека по изображению его лица, даст правоохранительным органам существенное преимущество в предотвращении преступлений

Джонатан В. Корн

Аспирант Харрисбургского университета науки и технологий

Научную статью с детальным описанием технологии должно было опубликовать авторитетное издательство Springer Nature. Однако после того, как более тысячи исследователей машинного обучения, социологов, историков и специалистов по этике выложили открытое письмо с осуждением представленной идеи, в Springer Nature сообщили, что издательство не будет в этом участвовать.

По мнению критиков ноу-хау Харрисбургского университета, исследование учёных «основано на ненадлежащих научных предпосылках и методах, которые были опровергнуты в последние годы». В открытом письме утверждается, что преступность невозможно предсказать без расовой предвзятости, так как «сама категория преступности основана на расистских предрассудках». Любой прогностический алгоритм, моделирующий преступность, будет воспроизводить только искажения, уже отражённые в системе правосудия, считают эксперты.

Новая разработка — не первая попытка проанализировать личность человека по его лицу с помощью современных технологий. В 2016 году исследователи из Шанхайского университета Цзяо Тонг также заявляли, что их алгоритм может предсказывать преступность посредством физиогномики, однако инженеры из Станфорда и компании Google опровергли выводы китайских учёных. В 2017 году пара исследователей уже из самого Станфорда утверждала, что их искусственный интеллект может определить сексуальную ориентацию человека. С критикой программы выступили ЛГБТ-организации. А в прошлом году исследователи из Кильского университета (Англия) заявили, что их алгоритм может предсказывать аутизм.